Curso SEO Técnico Avanzado Gratis

Índice de Contenidos del curso:

¿Que es el Crawl Budget (Periodicidad de Rastreo)? 🢅

Penalización del Crawl Budget 🢅

Cómo mejorar el Crawl Budget 🢅

Arquitectura web para SEO técnico 🢅

Estructura en silos: organización temática 🢅

Jerarquía lógica y profundidad controlada 🢅

URLs limpias, estables y semánticas 🢅

Enlazado interno estratégico 🢅

Gestión de paginaciones y filtros 🢅

Auditoría de arquitectura web 🢅

Cómo funciona la Indexación y el rastreo en Google 🢅

Cómo funciona el rastreo de Googlebot 🢅

Cómo Google decide qué se indexa y qué no 🢅

Sitemap XML: La guía para los Googlebots 🢅

Archivo robots.txt: control del rastreo 🢅

Meta robots y canonical: control de indexación 🢅

Qué es schema.org y cómo funciona 🢅

Tipos comunes de datos estructurados 🢅

Plugins recomendados para WordPress 🢅

Cómo validar los datos estructurados 🢅

Impacto en el SEO técnico 🢅

Core Web Vitals y velocidad de carga web 🢅

SEO móvil, Diseño Responsive, No AMP 🢅

Seguridad web, protocolo HTTPS, Hosting 🢅

Redirecciones y errores HTTP 🢅

Canonical, noindex y meta robots 🢅

Plugin Yoast SEO Canonical, noindex y meta robots 🢅

Datos duplicados y thin content 🢅

Qué es thin content (Contenido Pobre) y cómo detectarlo 🢅

Auditoría técnica y herramientas SEO 🢅

Checklist final y mantenimiento SEO 🢅

Qué es el SEO técnico y cómo funciona

Se denomina SEO técnico al conjunto de acciones que permiten y facilitan que los motores de búsqueda —especialmente Google— rastreen, interpreten e indexen correctamente una página web.

El SEO ténico no aborda aspectos acerca de palabras clave en el contenido ni de enlaces externos, sino que se centra en cómo está construida la web a nivel estructural, de código y de rendimiento.

Un sitio técnicamente optimizado facilita el trabajo de los Googlebots, mejora la eficiencia de rastreo, reduce errores y aumenta la probabilidad de que el contenido relevante de la página web sea indexado y posicionado.

Periodicidad de Rastreo, SEO técnico Crawl Budget

La Periodicidad de Rastreo, o Crawl budget, es la frecuencia con la que los Googlebots de Google acceden a tu sitio web y la cantidad de páginas que rastrean en cada sesión.

Este parámetro es fundamental en SEO técnico, determina cuántas url´s de tu sitio pueden ser procesada e indexadas.

Una Periodicidad baja significa que el Googlebot rastrea muchas URLs por visita, lo que mejora la cobertura de indexación.

En cambio, una Periodicidad alta indica que el Googlebot rastrea pocas URLs por sesión, lo que puede dejar contenido relevante fuera del índice.

Qué provoca una Alta Periodicidad del Crawl Budget

Que los googlebots «castiguen tu dominio» aumentando la Perioricidad en el rastreo es algo malo para tu página web.

A continuación se enumeran las causas por las que los bots de Google no rastrean o aumentan enormemente el periodo de rastreo de tus páginas.

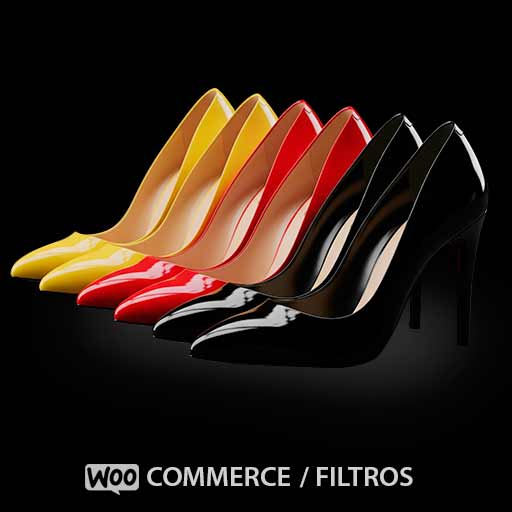

- Contenido duplicado por filtros: muchos sitios , sobre todo las tiendas online, generan URLs dinámicas mediante sistemas de filtrado.

Por ejemplo, en una tienda online, los filtros por colores, tallas o precios generan múltiples versiones de una misma página:- /zapatillas?color=rojo

- /zapatillas?color=rojo&talla=42

- /zapatillas?orden=precio_desc

Aunque el contenido principal es el mismo, cada combinación de parámetros crea una URL distinta que Google puede rastrear como si fuera una página nueva. Esto diluye la autoridad, genera duplicados y aumenta la periodicidad innecesariamente.

- Errores de rastreo: páginas que devuelven códigos 404, 500 o redirecciones en bucle.

- Páginas huérfanas: URLs sin enlaces internos que dificultan el acceso de los bots.

- Contenido sin valor SEO: páginas como login, carrito, resultados de búsqueda interna o formularios que no aportan valor al índice.

Cómo reducir la periodicidad de rastreo Crawl budget

- Bloquea URLs innecesarias en robots.txt: evita que los bots rastreen carpetas irrelevantes como /search/, /checkout/, /wp-admin/. Ejemplo:

User-agent: * Disallow: /search/ Disallow: /checkout/ Disallow: /wp-admin/ - Usa meta robots en páginas sin valor: aplica

<meta name="robots" content="noindex, follow">en páginas que deben ser rastreadas pero no indexadas. - Implementa etiquetas canonical: en versiones duplicadas o con parámetros, apunta siempre a la URL principal. Ejemplo:

<link rel="canonical" href="https://tupaginaweb.com/zapatillas"> - Optimiza el enlazado interno: asegúrate de que las páginas clave estén enlazadas desde otras secciones relevantes. Usa anchor text descriptivo y evita enlaces rotos.

- Revisa los logs del servidor: analiza qué URLs rastrea Googlebot, con qué frecuencia y qué errores encuentra. Herramientas como Screaming Frog Log Analyzer o JetOctopus pueden ayudarte.

- Envía un sitemap XML limpio: incluye solo URLs indexables y relevantes. Asegúrate de que el sitemap esté referenciado en el archivo robots.txt:

Sitemap: https://tupaginaweb.com/sitemap.xml - Corrige errores en Search Console: revisa los informes de cobertura y rastreo. Prioriza la solución de errores 404, redirecciones en cadena y páginas excluidas por canonical.

Cómo medir la periodicidad de rastreo

Accede a Google Search Console y entra en “Estadísticas de rastreo”. Observa el número de páginas rastreadas por día y el tiempo de respuesta. Si el número de URLs rastreadas por sesión aumenta y el tiempo de respuesta disminuye, estás reduciendo la periodicidad y mejorando la eficiencia del rastreo.

También puedes comprobar si Google accede con más frecuencia a tus nuevas URLs, lo que indica una mayor eficiencia en el rastreo y una mejor salud técnica del sitio.

Arquitectura web para SEO técnico

La arquitectura web es la forma en que se organiza, estructura y enlaza el contenido dentro de un sitio.

En SEO técnico, una arquitectura bien diseñada permite que los motores de búsqueda comprendan la jerarquía del sitio, rastreen eficientemente sus páginas y prioricen el contenido relevante para indexarlo correctamente.

Una arquitectura deficiente puede provocar problemas graves: páginas huérfanas, duplicadas, con escasa autoridad interna o inaccesibles para los bots. Estos errores afectan directamente al posicionamiento y a la experiencia del usuario.

Estructura en silos: organización temática

Una estructura en silos agrupa las páginas por temáticas coherentes y jerárquicas.

Cada silo representa una categoría principal y contiene subpáginas relacionadas.

Esta organización facilita la comprensión semántica del sitio por parte de Google y mejora la distribución de autoridad interna.

Ejemplo de estructura en silos para una página de SEO y SEM:

/seo/

/seo/tecnico/

/seo/local/

/seo/copywriting/

/sem/

/sem/google-ads/

/sem/display/

/sem/remarketing/- El silo

/seo/agrupa todo el contenido relacionado con posicionamiento orgánico. - El silo

/sem/contiene páginas sobre publicidad en buscadores. - Las subpáginas dentro de cada silo están enlazadas entre sí, pero no cruzan enlaces con otros silos, salvo desde la home o menús globales.

Este modelo mejora la relevancia temática, facilita el rastreo y refuerza la autoridad de cada categoría.

Jerarquía lógica y profundidad controlada

La jerarquía del sitio debe ser clara y coherente.

Las páginas clave deben estar a menos de tres clics desde la home.

Cuanto más profunda esté una URL, menos autoridad recibe y más difícil es que sea rastreada con frecuencia.

- Evita estructuras con más de tres niveles sin enlaces intermedios.

- Usa breadcrumbs para reforzar la jerarquía y facilitar la navegación.

- Incluye mapas del sitio HTML para mejorar la accesibilidad.

URLs limpias, estables y semánticas

Las URLs deben ser cortas, descriptivas y reflejar la jerarquía del contenido.

Evita parámetros innecesarios, identificadores técnicos o números sin contexto.

- Correcto:

/curso-seo-tecnico - Incorrecto:

/curso?id=123&ref=abc

Las URLs deben mantenerse estables en el tiempo.

Si necesitas modificarlas, aplica redirecciones 301 correctamente para conservar la autoridad.

Enlazado interno estratégico

El enlazado interno distribuye la autoridad entre las páginas y guía a los bots hacia el contenido más importante.

Cada página debe recibir enlaces desde otras páginas relevantes del sitio.

- Usa anchor text descriptivo y natural que indique el contenido del destino.

- Evita enlaces rotos o que apunten a redirecciones innecesarias.

- Prioriza el enlazado hacia páginas con intención de búsqueda clara.

- Incluye enlaces contextuales dentro del contenido, no solo en menús o footers.

Gestión de paginaciones y filtros

En sitios con listados extensos como blogs o tiendas online, la paginación y los filtros deben gestionarse correctamente para evitar duplicados y problemas de rastreo.

- Usa

rel="next"yrel="prev"para indicar la relación entre páginas paginadas. - Evita que las páginas paginadas compitan con la principal en términos de contenido y autoridad.

- Los filtros dinámicos (por color, talla, precio, etc.) generan URLs con parámetros que pueden duplicar contenido.

Ejemplo:- /zapatillas?color=rojo

- /zapatillas?color=rojo&talla=42

- /zapatillas?orden=precio_desc

- Bloquea estos parámetros en el archivo

robots.txtsi no aportan valor SEO:Disallow: /*?color= Disallow: /*?orden= Disallow: /*?talla=User-agent: * Disallow: /*?* Disallow: /*&* Disallow: /*?color= Disallow: /*?precio= Disallow: /*?talla= Disallow: /*?orden= Allow: / Sitemap: https://tusitio.com/sitemap.xml

Usando esta modificación en el archivo robots.txt, Google ni siquiera va a entrar a rastrear esas URLs, ahorrando recursos de rastreo y pudiéndolos invertir en aquellos que nos interesa de verdad.

IMPORTANTE: Antes de bloquear las páginas de filtros en el robots.txt tienes que eliminarlas desde Google Search Console.

- Aplica

rel="canonical"en todas las versiones filtradas, apuntando a la URL principal:<link rel="canonical" href="https://toledoseopro.com/zapatillas">

Auditoría de arquitectura web

Para detectar todas estas fallas en la arquitectura SEO de tu página puedes usar varias herramientas como Screaming Frog, Sitebulb o JetOctopus.

El software Screaming Frog en su versión gratuita es suficiente para auditar-analizar sitios web pequeños y medianos.

Revisa el enlazado interno, la profundidad de las URLs, los códigos de estado y la distribución de autoridad.

Una arquitectura optimizada mejora la periodicidad de rastreo, reduce errores y facilita la indexación de contenido estratégico.

Cómo funciona la Indexación y el rastreo en Google

La indexación y el rastreo son procesos fundamentales en SEO técnico.

El rastreo es la acción mediante la cual los bots de Google acceden a las páginas de tu sitio.

La indexación es el paso posterior, donde esas páginas se almacenan en el índice de Google y pueden aparecer en los resultados de búsqueda.

Una web bien rastreada no garantiza que todas sus páginas sean indexadas.

Cómo funciona el rastreo de Googlebot

Googlebot utiliza enlaces internos, sitemaps y datos de Search Console para descubrir nuevas URLs.

El bot prioriza el rastreo según la autoridad de la página, la frecuencia de actualización y la eficiencia técnica del sitio.

- Las páginas con enlaces entrantes son rastreadas con mayor frecuencia.

- Las páginas huérfanas o profundas pueden tardar en ser rastreadas.

- Los errores técnicos pueden bloquear el acceso del Googlebot.

Para que el contenido aparezca en Google, debe ser accesible, relevante, único y técnicamente correcto.

Cómo Google decide qué se indexa y qué no

Google evalúa cada página rastreada antes de indexarla.

Si detecta contenido duplicado, pobre, bloqueado o sin valor, puede excluirla del índice.

También influye la periodicidad de rastreo y la estructura del sitio.

- Las páginas con

noindexno se indexan aunque sean rastreadas. - Las páginas duplicadas sin canonical pueden ser ignoradas.

- Las páginas bloqueadas por

robots.txtno se rastrean ni se indexan.

Sitemap XML: La guía para los Googlebots

El sitemap.xml es un archivo que lista las URLs que deseas que Google rastree e indexe. Es una herramienta clave para mejorar la cobertura de indexación, especialmente en sitios grandes o con contenido dinámico.

- Incluye solo URLs indexables y relevantes.

- Actualiza el sitemap automáticamente cuando se publica nuevo contenido.

- Evita incluir URLs con

noindexo bloqueadas porrobots.txt. - Referencia el sitemap en el archivo

robots.txt:Sitemap: https://tupaginaweb.com/sitemap.xml

Archivo robots.txt: control del rastreo

El robots.txt es un archivo que indica a los bots qué partes del sitio no deben rastrear. No impide la indexación directa, pero sí evita que el contenido bloqueado sea accedido por los bots.

- Bloquea carpetas técnicas o sin valor SEO:

User-agent: * Disallow: /wp-admin/ Disallow: /checkout/ Disallow: /search/ - No bloquees contenido que quieras posicionar.

- Verifica que no haya conflictos entre

robots.txtymeta robots.

Meta robots y canonical: control de indexación

Las etiquetas meta robots y rel="canonical" permiten controlar qué páginas deben ser indexadas y cuál es su versión principal.

- Usa

noindex, followen páginas sin valor SEO. - Aplica

canonical

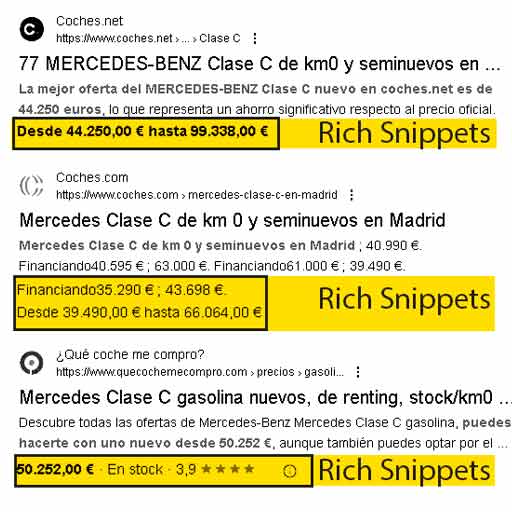

Datos estructurados y Rich Snippets

Los datos estructurados son fragmentos de código que permiten a los motores de búsqueda entender mejor el contenido de una página.

Se implementan siguiendo el estándar schema.org y pueden mejorar la visibilidad del sitio en los resultados de búsqueda mediante los Rich snippets.

Un Rich Snippet es una versión enriquecida de texto que aparece en los resultados orgánicos de Google.

Los Rich Snippets los genera Google a partir del Marcado Schema. Suele generarlos en páginas con gran contenido que se actualiza frecuentemente y tienen implementado el Marcado Schema.

Las versiones enriquecidas de texto puede incluir valoraciones con iconos de estrellitas, precios, fechas de eventos, preguntas frecuentes o imágenes, entre otros elementos. Las páginas con estas versiones enriquecidas aumentan el CTR y la relevancia del resultado.

Qué es Schema.org y cómo funciona

Schema.org es una iniciativa conjunta de Google, Bing, Yahoo y Yandex que define un vocabulario común para etiquetar el contenido web. Se implementa normalmente en formato JSON-LD, aunque también se admite Microdata y RDFa.

- JSON-LD es el formato recomendado por Google por su facilidad de implementación y mantenimiento.

- El código se coloca dentro de una etiqueta

<script type="application/ld+json">en el<head>o el<body>de la página.

Tipos comunes de datos estructurados

Los tipos más utilizados en SEO técnico son:

- Article: para entradas de blog o noticias.

- Course: para cursos online como los de toledoseopro.com.

- Product: para fichas de productos en eCommerce.

- FAQPage: para secciones de preguntas frecuentes.

- BreadcrumbList: para rutas de navegación internas.

Ejemplo de marcado JSON-LD para un curso como el que estás haciendo:

{ "@context": "https://schema.org", "@type": "Course", "name": "Curso SEO Técnico Avanzado", "description": "Aprende a optimizar tu web para buscadores.", "provider": { "@type": "Organization", "name": "ToledoSEOPro", "url": "https://toledoseopro.com" } }Plugins recomendados para WordPress

Si usas WordPress dispones de varios plugings que se encargan de «armar» el JSON algunos de forma automática, permitiéndote desentenderte del Marcado Schema.

- Yoast SEO Pro: Plugin con configuración automática de SEO técnico incluyendo Datos Estructurados para múltiples tipos de Schema (Recomendado por ToledoSEOpro).

- Rank Math SEO: Plugin completo que incluye soporte para múltiples tipos de schema, integración con Search Console y configuración automática de datos estructurados.

- Schema Pro: Permite aplicar más de 20 tipos de schema sin escribir código. Ideal para sitios con cursos, productos, reseñas o eventos.

Cómo validar los datos estructurados

Google ofrece herramientas para comprobar si el marcado está correctamente implementado:

- Rich Results Test: valida si el contenido puede generar snippets enriquecidos.

- Schema Markup Validator: comprueba la sintaxis y estructura del código.

Es importante corregir todos los errores y advertencias para asegurar que Google interprete correctamente el marcado.

Buenas prácticas en datos estructurados

- Marca solo el contenido que está visible para el usuario.

- No uses datos estructurados para manipular el ranking o mostrar información falsa.

- Evita duplicar el mismo tipo de marcado en múltiples páginas si no es relevante.

- Actualiza el marcado cuando cambie el contenido de la página.

Impacto en el SEO técnico

Los datos estructurados no garantizan una mejora directa en el posicionamiento, pero sí aumentan la probabilidad de obtener Rich Snippets, Google decidirá si mostrarlos y cuando hacerlo, lo que mejora el CTR y la visibilidad.

Además, ayudan a Google a entender mejor la intención y el contexto del contenido, lo que puede influir positivamente en la indexación y en la clasificación semántica.

Core Web Vitals y velocidad de carga web

Los Core Web Vitals son métricas definidas por Google para evaluar la experiencia de usuario en términos de velocidad, interactividad y estabilidad visual.

Estas métricas se han convertido en factores de posicionamiento desde 2021 y son fundamentales en cualquier auditoría de SEO técnico.

Qué mide cada Core Web Vital

- LCP (Largest Contentful Paint): mide el tiempo que tarda en mostrarse el elemento más grande visible en el viewport. Ideal: menos de 2.5 segundos.

- FID (First Input Delay): mide el tiempo que tarda la página en responder a la primera interacción del usuario. Ideal: menos de 100 ms.

- CLS (Cumulative Layout Shift): mide la estabilidad visual durante la carga. Ideal: menos de 0.1.

Cómo se recogen los datos de Core Web Vitals

Google obtiene estas métricas a través de dos fuentes:

- Laboratorio: simulaciones en herramientas como Lighthouse (extension de Chrome) o PageSpeed Insights. No reflejan datos reales de usuarios.

- Campo (Field Data): datos reales de usuarios recogidos por el navegador Chrome a través del informe Chrome UX Report y mostrados en Search Console y PageSpeed Insights.

Cuánto tarda una web en generar datos reales de Core Web Vital

Para que una página web tenga estadísticas reales de Core Web Vitals (field data), debe cumplir las siguientes condiciones:

- Recibir tráfico suficiente desde navegadores compatibles (principalmente Chrome).

- Contar con al menos 28 días consecutivos de actividad para que Google agregue los datos en sus informes.

- Las métricas se actualizan en ciclos mensuales, por lo que los cambios técnicos pueden tardar semanas en reflejarse.

En resumen, una web nueva o con poco tráfico no mostrará datos reales de Core Web Vitals hasta que alcance un volumen mínimo de usuarios y se mantenga activa durante al menos un mes.

Mientras tanto, solo se podrá trabajar con datos de laboratorio.

Herramientas para medir y mejorar

- PageSpeed Insights: muestra datos de laboratorio y de campo.

- Web.dev: documentación oficial y recomendaciones técnicas.

- Search Console: informe de experiencia en la página con datos reales.

Cómo optimizar cada métrica

- Para LCP: Optimiza las imágenes y/o vídeos, reduce el número de fuentes tipográficas y recursos críticos. Usa lazy loading y precarga de elementos clave.

- Para FID: Reduce el uso de JavaScript pesado, divide tareas largas y evita bloqueos en el hilo principal.

- Para CLS: Reserva espacio para elementos dinámicos, evita cargas tardías de fuentes y no inserte contenido por encima del que ya está renderizado.

Impacto en el SEO técnico

Una web con buenos Core Web Vitals no solo mejora el posicionamiento, sino que reduce el rebote, aumenta la conversión y mejora la percepción de marca.

Google prioriza las páginas que ofrecen una experiencia rápida, estable y fluida, especialmente en dispositivos móviles.

SEO móvil, Diseño Responsive, No AMP

Desde 2020, Google aplica el mobile-first indexing, lo que significa que evalúa primero la versión móvil de una web para determinar su posicionamiento.

Por tanto, el diseño responsive y la optimización móvil son fundamentales en el SEO técnico.

Una web que no esté adaptada correctamente a dispositivos móviles puede sufrir penalizaciones, pérdida de tráfico orgánico y exclusión parcial del índice de Google.

Diseño responsive y experiencia móvil

El diseño responsive permite que una web se adapte automáticamente al tamaño de pantalla del dispositivo. Esto mejora la usabilidad, reduce el rebote y facilita el rastreo por parte de los bots móviles.

- Usa

@media queriespara adaptar el diseño a distintos tamaños de pantalla. - Evita contenido oculto en móvil que sí aparece en desktop.

- Verifica que los botones y enlaces tengan tamaño táctil adecuado.

- Comprueba que el contenido se cargue correctamente en conexiones móviles lentas.

Problemas graves con AMP

AMP (Accelerated Mobile Pages) fue una tecnología promovida por Google para mejorar la velocidad de carga en dispositivos móviles.

Pero preescindir de javascript, entre otras cosas, bajó la calidad de experiencia de usuario.

Aunque AMP tuvo ventajas iniciales, su uso presenta riesgos técnicos y estratégicos que afectan muy negativamente al SEO.

Desde 2023, Google ha dejado de dar prioridad a AMP en sus resultados, y ya no es requisito para aparecer en carruseles de noticias ni en Top Stories.

- Duplicidad de URLs: AMP genera versiones alternativas de cada página, como

/page/amp/, lo que puede provocar conflictos de indexación si no se gestionan correctamente conrel="canonical". - Pérdida de control: AMP impone restricciones en el uso de JavaScript, estilos personalizados y elementos interactivos, lo que limita la capacidad de optimización y personalización.

- Desincronización de contenido: si el contenido AMP no se actualiza en paralelo con la versión principal, puede mostrar información obsoleta o incompleta.

- Problemas de rastreo: los bots pueden priorizar la versión AMP si no se configura correctamente, dejando la versión principal con menor visibilidad.

- Impacto negativo en Core Web Vitals: muchas implementaciones AMP no cumplen con las métricas actuales de rendimiento, especialmente en CLS y FID.

Desde 2023, Google ha dejado de dar prioridad a AMP en sus resultados, y ya no es requisito para aparecer en carruseles de noticias ni en Top Stories.

Por tanto, no se recomienda implementar AMP en nuevos proyectos, y se aconseja eliminarlo progresivamente en sitios existentes.

Cómo auditar la versión móvil

- Usa Mobile-Friendly Test para verificar la adaptabilidad.

- Revisa el informe de “Usabilidad móvil” en Search Console.

- Comprueba que el contenido móvil sea idéntico al de escritorio en estructura y semántica.

- Evita redirecciones automáticas desde móvil a subdominios tipo

m.example.com, ya obsoletos.

Impacto en el SEO técnico

Una página web optimizada para móviles mejora la indexación, la experiencia de usuario y el posicionamiento en búsquedas realizadas desde smartphones.

El diseño responsive, junto con una arquitectura clara y una velocidad de carga adecuada, es esencial para competir en el entorno actual.

El uso de AMP, en cambio, puede generar duplicidad, pérdida de control y problemas de rastreo que afectan directamente al rendimiento SEO.

Por eso, en 2025, la recomendación técnica es clara: priorizar diseño responsive y eliminar AMP progresivamente.

Seguridad web, protocolo HTTPS, Hosting

La seguridad web es un componente esencial del SEO técnico. Y no solamente para sitios de comercio electrónico o tiendas online.

Desde el año 2014 Google considera el uso de HTTPS un factor de posicionamiento.

Los navegadores modernos muestran advertencias de peligro cuando una web no utiliza un certificado SSL válido. Esto influye muy negativamente en el posicionamiento y en el CTR.

Además, una web segura protege la integridad de los datos, mejora la confianza del usuario y evita penalizaciones por contenido mixto o vulnerabilidades.

Qué es HTTPS y cómo funciona

HTTPS (HyperText Transfer Protocol Secure) es la versión segura del protocolo HTTP.

Utiliza cifrado TLS (Transport Layer Security) para proteger la comunicación entre el navegador del usuario y el servidor web.

Esto impide que terceros intercepten o manipulen los datos transmitidos.

- HTTPS cifra el contenido, las cookies, los formularios y las credenciales.

- Evita ataques de tipo man-in-the-middle y suplantación de identidad.

- Es obligatorio para cualquier sitio que recoja datos personales o financieros.

Cómo implementar HTTPS correctamente

- Instala un certificado SSL válido. Puedes usar Let’s Encrypt (gratuito) o proveedores como Comodo, DigiCert o Sectigo.

- Configura el servidor para redirigir todas las URLs HTTP a HTTPS mediante redirección 301 permanente.

- Actualiza todos los enlaces internos, canonicals, sitemaps y recursos para que usen la versión segura.

- Verifica que no haya contenido mixto: elementos HTTP (scripts, imágenes, fuentes) cargados en páginas HTTPS.

- Incluye la versión HTTPS en Search Console y en el archivo

robots.txt:Sitemap: https://tupaginaweb.com/sitemap.xml

Proveedor recomendado: Banahosting

Para implementar HTTPS de forma sencilla y fiable, desde ToledoSEOpro recomendamos Banahosting.

Este proveedor ofrece:

- Certificado SSL gratuito incluido en todos sus planes.

- Servidores LiteSpeed para máxima velocidad y rendimiento.

- Transferencia de datos ilimitada.

- Infraestructura segura con copias de seguridad automáticas.

- Precios competitivos desde 5 € al mes.

- Soporte técnico 24/7 en español e inglés.

Banahosting es una opción ideal para proyectos SEO que requieren velocidad, estabilidad y seguridad sin complicaciones técnicas.

Su integración con WordPress y cPanel facilita la gestión de certificados y redirecciones HTTPS desde el primer día.

Errores comunes en la migración a HTTPS

- Redirecciones mal configuradas: redirecciones en bucle, uso de 302 en lugar de 301, o redirecciones parciales.

- Contenido mixto: carga de elementos no seguros que provocan advertencias en el navegador y bloqueos de rastreo.

- Duplicidad de versiones: si no se redirige correctamente, Google puede indexar tanto la versión HTTP como la HTTPS, generando contenido duplicado.

- Canonical incorrecto: canonicals que apuntan a la versión HTTP en páginas HTTPS, lo que anula la migración.

Cómo auditar la seguridad web

- Usa SSL Server Test para verificar la configuración del certificado.

- Revisa los informes de cobertura en Search Console para detectar errores de rastreo relacionados con HTTPS.

- Utiliza herramientas como Screaming Frogpara identificar contenido mixto y enlaces internos no seguros.

Impacto en el SEO técnico

Una implementación correcta de HTTPS mejora la confianza del usuario, evita penalizaciones por inseguridad y garantiza que el contenido sea rastreado e indexado sin restricciones.

Además, permite el uso de funcionalidades avanzadas como datos estructurados, formularios interactivos y autenticación segura sin comprometer la integridad del sitio.

Redirecciones y errores HTTP

Si renombras un enlace permanente de cualquier página Web, cuando los usuarios la encuentren en Google y pinchen en ella saldrá un error 404.

Si no se corrige este error, con el tiempo, la página afectada desaparecerá del índice de Google.

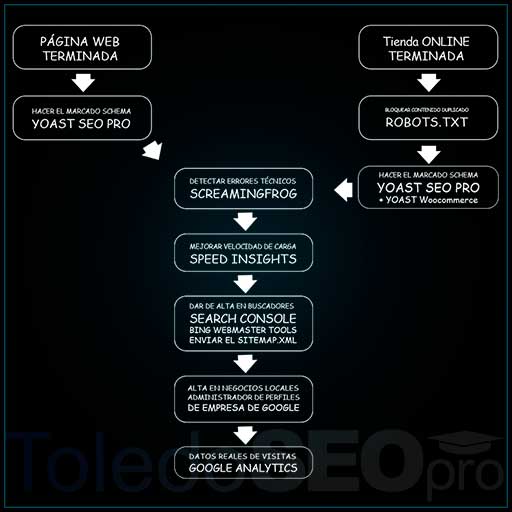

ToledoSEOpro recomienda usar el plugin Yoast SEO pro, ya que además soporta redirecciones.

Las redirecciones y los códigos de estado HTTP son elementos clave en SEO técnico.Determinan cómo los bots interpretan el comportamiento de las URLs, cómo se transmite la autoridad entre páginas y qué contenido se considera válido para indexar.

Una mala gestión de redirecciones o errores puede provocar pérdida de tráfico, duplicidad, exclusión del índice y penalizaciones.

Tipos de redirecciones y su uso correcto

- 301 (permanente): indica que una URL ha sido movida de forma definitiva. Transfiere casi toda la autoridad SEO a la nueva URL.

Es la opción recomendada para migraciones, cambios de estructura o consolidación de contenido. - 302 (temporal): indica que la redirección es provisional. No transfiere autoridad y puede confundir a los bots si se usa de forma prolongada.

- 307 (temporal con método preservado): similar a 302 pero conserva el método HTTP original (POST, GET). Poco usado en SEO.

- Meta refresh: redirección basada en HTML. No recomendada para SEO, ya que puede ser ignorada por los bots.

Errores HTTP más comunes en SEO

- 404 (Not Found): indica que la página no existe. Si no se gestiona, puede provocar pérdida de autoridad y mala experiencia de usuario.

- 410 (Gone): indica que la página ha sido eliminada intencionadamente. Es más claro para los bots que el 404.

- 500 (Internal Server Error): error del servidor. Impide el rastreo y puede bloquear el acceso a todo el sitio.

- 503 (Service Unavailable): usado para mantenimiento temporal. Debe incluir cabecera

Retry-Afterpara indicar cuándo volver a intentar el rastreo.

Cómo auditar redirecciones y errores

- Usa Screaming Frog para rastrear el sitio y detectar redirecciones, errores y cadenas innecesarias.

- Revisa los informes de cobertura en Search Console para identificar páginas excluidas por errores HTTP.

- Evita redirecciones en cadena (301 → 301 → 301), ya que diluyen la autoridad y ralentizan el rastreo.

- Corrige enlaces internos que apunten a URLs redirigidas o inexistentes.

Buenas prácticas en gestión de redirecciones

- Usa redirecciones 301 para consolidar contenido, migrar URLs o eliminar duplicados.

- Evita redirecciones temporales salvo en casos muy específicos.

- No redirijas todas las páginas rotas a la home. Esto confunde a los bots y puede provocar penalizaciones.

- Actualiza los enlaces internos para que apunten directamente a la URL final, sin pasar por redirecciones.

Impacto en el SEO técnico

Una gestión correcta de redirecciones y errores HTTP mejora la eficiencia del rastreo, conserva la autoridad de las páginas y evita exclusiones del índice.

Además, protege la experiencia del usuario y facilita la migración de contenido sin pérdida de posicionamiento.

Canonical, noindex y meta robots

Las etiquetas canonical, noindex y meta robots son herramientas fundamentales en SEO técnico.

Controlan la indexación, evitan contenido duplicado y guian a los motores de búsqueda sobre cómo deben tratar cada página.

Una implementación incorrecta de estas etiquetas puede provocar exclusión de contenido valioso, duplicidad en el índice, pérdida de autoridad y conflictos de rastreo. Por eso deben gestionarse con precisión y coherencia.

Etiqueta canonical: control de duplicidad

La etiqueta rel="canonical" indica cuál es la versión principal de una página cuando existen múltiples URLs con contenido similar o idéntico. Google utiliza esta señal para consolidar la autoridad y evitar indexar duplicados.

- Se coloca en el

<head>de la página duplicada. - Debe apuntar a la URL canónica absoluta, con protocolo HTTPS incluido.

- Ejemplo:

<link rel="canonical" href="https://toledoseopro.com/curso-seo-tecnico"> - No debe usarse en páginas con

noindex, ya que genera conflicto. - Evita canonicals cruzados o en bucle.

Etiqueta noindex: exclusión del índice

La etiqueta noindex indica que una página no debe ser incluida en el índice de Google, aunque pueda ser rastreada.

Es útil para excluir contenido sin valor SEO, como filtros, resultados internos, páginas de login o agradecimiento.

- Se coloca en el

<head>de la página:<meta name="robots" content="noindex, follow"> - La opción

followpermite que los enlaces internos sean rastreados. - No usar

noindexen páginas que tengan enlaces entrantes o autoridad acumulada. - Evita aplicar

noindexen masa sin revisar el impacto en el tráfico.

Meta robots: configuración avanzada

La etiqueta meta robots permite combinar instrucciones sobre indexación y rastreo. Las combinaciones más comunes son:

index, follow: página indexable, enlaces rastreables.noindex, follow: página no indexable, pero sus enlaces sí.noindex, nofollow: página excluida y enlaces ignorados.index, nofollow: página indexada, pero sin rastrear sus enlaces (raro en SEO técnico).

También se pueden usar atributos como noarchive, nosnippet o max-snippet para controlar la presentación en los resultados de búsqueda.

Errores comunes y cómo evitarlos

- Canonical hacia una URL noindex: Google ignora la señal y puede excluir ambas versiones.

- Uso de noindex en páginas estratégicas: puede eliminar contenido valioso del índice sin intención.

- Meta robots mal configurado: puede bloquear el rastreo de enlaces internos y afectar la arquitectura.

- Canonicals dinámicos mal generados: en CMS mal configurados, pueden apuntar a URLs incorrectas.

Cómo auditar estas etiquetas

- Usa Screaming Frog para rastrear y extraer canonicals, meta robots y encabezados HTTP.

- Verifica en Google Search Console qué páginas están excluidas por

noindexo conflictos de canonical. - Revisa manualmente las páginas clave para asegurar que no estén bloqueadas por error.

Plugin Yoast SEO, Canonical, noindex y meta robots

Si usas WordPress puedes utilizar los plugins Yoast SEO y Yoast SEO para WooCommerce para configurar todos estos parámetros en cada página, entrada de Blog o cada artículo a la venta en WooCommerce.

Impacto en el SEO técnico

Una gestión precisa de canonical, noindex y meta robots permite consolidar autoridad, evitar duplicados, controlar la indexación y optimizar la eficiencia del rastreo.

Son herramientas críticas para mantener una arquitectura limpia y un índice relevante.

Datos duplicados y Thin Content (contenido pobre)

El contenido duplicado y el contenido pobre (thin content) son dos de los problemas más graves en SEO técnico.

Afectan directamente a la indexación, diluyen la autoridad, generan confusión semántica y pueden provocar penalizaciones algorítmicas por parte de Google.

Qué se considera contenido duplicado

El contenido duplicado ocurre cuando varias URLs muestran el mismo contenido o uno muy similar.

Google puede indexar solo una versión y excluir el resto, o incluso ignorar todas si no identifica una versión principal clara.

- Duplicados internos: Versiones con parámetros, paginaciones, artículos de venta online con filtros (WooCommerce) o URLs mal estructuradas que muestran el mismo contenido.

- Duplicados externos: contenido copiado de otros sitios o republicado sin cambios sustanciales.

- Problemas con etiquetas canonical: Canonicals mal configuradas que apuntan a sí mismas o a URLs no relevantes.

Ejemplos comunes:

/producto?color=rojo /producto?color=rojo&talla=42 /producto?orden=precio_descEstas URLs pueden mostrar el mismo listado de productos, pero cada una genera una versión duplicada si no se gestionan correctamente.

Qué es thin content y cómo detectarlo

El thin content es contenido superficial, escaso o sin valor añadido.

Google lo considera irrelevante para el usuario y puede excluirlo del índice o penalizar el dominio si está presente en grandes cantidades.

- Páginas con menos de 300 palabras sin estructura ni profundidad.

- Fichas de producto sin descripción original ni elementos multimedia.

- Páginas de categoría que solo muestran enlaces sin contexto.

- Contenido generado automáticamente sin revisión editorial.

Cómo solucionar contenido duplicado

- Implementa

rel="canonical"en todas las versiones duplicadas, apuntando a la URL principal. - Bloquea parámetros innecesarios en

robots.txtsi no aportan valor SEO. - Evita enlaces internos hacia URLs duplicadas o filtradas.

- Configura Search Console para indicar cómo tratar los parámetros de URL.

- Revisa los informes de cobertura para identificar exclusiones por duplicidad.

Cómo mejorar el thin content

- Amplía el contenido con información útil, multimedia, tablas, ejemplos y enlaces relevantes.

- Evita plantillas repetitivas en fichas de producto. Redacta descripciones únicas.

- Incluye datos estructurados para enriquecer el contenido y facilitar su interpretación por parte de Google.

- Fusiona páginas similares en una sola más completa si no tienen tráfico ni valor individual.

- Elimina o redirige páginas que no aportan valor y no pueden ser mejoradas.

Herramientas para detectar duplicados y contenido pobre

- Siteliner: detecta duplicados internos y páginas con poco contenido.

- Copyscape: identifica contenido copiado de otros sitios.

- Screaming Frog: permite filtrar páginas por número de palabras, canonicals y códigos de estado.

Impacto en el SEO técnico

Eliminar duplicados y mejorar el contenido pobre aumenta la relevancia del sitio, mejora la eficiencia del rastreo, refuerza la autoridad temática y reduce el riesgo de penalizaciones. Es una tarea crítica en cualquier auditoría técnica seria.

Auditoría técnica y herramientas SEO

La auditoría técnica es el proceso de análisis profundo de una web para detectar errores, oportunidades de mejora y factores que afectan al rastreo, indexación y posicionamiento.

Es una fase crítica en cualquier estrategia SEO seria, y debe realizarse con herramientas especializadas que permitan revisar cada aspecto técnico del sitio.

Objetivos de una auditoría técnica

- Detectar errores de rastreo, indexación y arquitectura.

- Identificar problemas de contenido duplicado, thin content y canibalización.

- Revisar la implementación de etiquetas meta, canonical, robots y sitemaps.

- Evaluar el rendimiento, la velocidad de carga y los Core Web Vitals.

- Comprobar la seguridad, el uso de HTTPS y la configuración del servidor.

Herramientas imprescindibles para auditar

- Screaming Frog: Es un software de escritorio rastreador que permite analizar URLs, enlaces internos, canonicals, redirecciones, meta robots, encabezados HTTP y más.

- Sitebulb: Herramienta con visualización gráfica de arquitectura, análisis de rastreo, datos estructurados y Core Web Vitals.

- Google Search Console: Plataforma oficial para revisar cobertura de indexación, estadísticas de rastreo, usabilidad móvil y rendimiento.

- Google PageSpeed Insights: Herramienta online de análisis de velocidad de carga y Core Web Vitals con datos de laboratorio y de campo.

- JetOctopus: herramienta avanzada para analizar logs del servidor, comportamiento de bots y eficiencia de rastreo.

Cómo estructurar una auditoría técnica

- Rastreo completo del sitio: analiza todas las URLs accesibles, detecta errores 404, redirecciones, canonicals y meta robots.

- Revisión de indexación: compara el número de páginas rastreadas con las indexadas. Identifica exclusiones por duplicado, noindex o errores.

- Evaluación de arquitectura: revisa la jerarquía, profundidad de clics, enlaces internos y estructura en silos.

- Análisis de contenido: detecta duplicados, thin content, canibalización y oportunidades de mejora semántica.

- Rendimiento y UX: mide Core Web Vitals, velocidad de carga, estabilidad visual y experiencia móvil.

- Seguridad y servidor: comprueba HTTPS, certificados SSL, encabezados de seguridad y configuración del hosting.

Frecuencia recomendada de auditoría

La auditoría técnica debe realizarse:

- Al iniciar cualquier proyecto SEO.

- Después de migraciones, rediseños o cambios estructurales.

- Cada 3 a 6 meses en sitios activos o con alto volumen de tráfico.

- Mensualmente en proyectos críticos o con alta competencia.

Impacto en el SEO técnico

Una auditoría técnica bien ejecutada permite detectar errores invisibles, optimizar el rastreo, consolidar la autoridad, mejorar la experiencia del usuario y preparar el sitio para escalar posiciones en los resultados de búsqueda.

Es la base sobre la que se construye cualquier estrategia SEO sostenible y profesional.

Checklist final y mantenimiento SEO

Una vez completada la optimización técnica de una web, es fundamental establecer un sistema de mantenimiento y revisión periódica.

El SEO técnico no es una tarea puntual, sino un proceso continuo que requiere vigilancia, ajustes y validación constante.

Esta checklist final sirve como guía para verificar que todos los elementos críticos de tu página web están correctamente implementados.

Checklist técnico de verificación

- ✔️ Arquitectura web clara, jerárquica y en silos.

- ✔️ URLs limpias, estables y semánticas.

- ✔️ Enlazado interno optimizado y sin enlaces rotos.

- ✔️ Sitemap XML actualizado y referenciado en robots.txt.

- ✔️ Archivo robots.txt bien configurado, sin bloqueos innecesarios.

- ✔️ Etiquetas

canonicalcorrectamente implementadas. - ✔️ Páginas sin valor marcadas con

noindexyfollow. - ✔️ Datos estructurados validados y sin errores.

- ✔️ Core Web Vitals dentro de los rangos recomendados.

- ✔️ Diseño responsive funcional en todos los dispositivos.

- ✔️ HTTPS activo, sin contenido mixto ni redirecciones incorrectas.

- ✔️ Redirecciones 301 bien configuradas, sin cadenas ni bucles.

- ✔️ Sin errores 404, 500 o páginas excluidas por duplicidad.

- ✔️ Thin content eliminado o mejorado.

- ✔️ Search Console vinculado y monitorizado.

Mantenimiento técnico mensual

Para mantener la salud SEO de la web, se recomienda realizar revisiones técnicas mensuales.

Estas tareas permiten detectar problemas antes de que afecten al posicionamiento y asegurar que el sitio sigue cumpliendo con las directrices de Google.

- Revisar los informes de cobertura e indexación en Search Console.

- Analizar el rastreo y la periodicidad con herramientas como JetOctopus o logs del servidor.

- Comprobar la velocidad de carga y los Core Web Vitals en PageSpeed Insights.

- Detectar nuevos errores 404, redirecciones o contenido duplicado con Screaming Frog.

- Validar los datos estructurados y corregir advertencias.

- Auditar el enlazado interno y la arquitectura si se han añadido nuevas secciones.

- Verificar que el sitemap esté actualizado y que el archivo robots.txt no bloquee contenido nuevo.

Actualizaciones y vigilancia SEO

- Monitorizar cambios en el algoritmo de Google y adaptar la estrategia técnica.

- Actualizar los plugins, CMS y servidores para evitar vulnerabilidades.

- Revisar la indexación de nuevas URLs y eliminar las que no aportan valor.

- Mantener una documentación técnica de cambios realizados y decisiones tomadas.

Impacto del mantenimiento en el SEO técnico

El mantenimiento técnico garantiza que la web siga siendo rastreable, indexable, rápida, segura y relevante.

Evita pérdidas de tráfico por errores acumulados, mejora la estabilidad del posicionamiento y permite escalar en entornos competitivos.

Un sitio técnicamente sano es la base de cualquier estrategia SEO sostenible.